こんにちは、小寺です。

re:Inforce初日の一番最初に参加した「GRC202 | Building AI responsibly with a GRC strategy, featuring Anthropic」についてレポートします!

AIの普及について

AIのマーケット拡大は目を見張るものがあり、生成AIの普及によりAI業界は2030年までに2030 年までに世界経済に 15 兆 7,000 億ドルが追加されることになります。

AI への進歩と投資は指数関数的な額に達しているといえるでしょう。

AWSでは、AIモデルを構築しているすべての人を対象に技術研究を行っており、独自のデータも公開されています。

責任あるAI戦略

よく「Responsible AI」という言葉を聞かれることがあるかと思います。

AWSの責任あるAI戦略は法の支配、人権と尊厳、包括性、プライバシー、公正さを尊重することを基盤としています。

トレーニングされたAIモデルを使って特定の有害な情報を公開しないことを重視しています。

例えば、モデルを使用することで、兵器、化学兵器、生物兵器、核兵器を製造するためのAI はそれを可能にする情報を確実に持っており、選挙を特定の方向に誘導するための誤った情報キャンペーンを支援してしまうこともあるかもしれません。

AIの安全性に関する懸念点を払拭するために20年の経験をもとに日々活動しています。

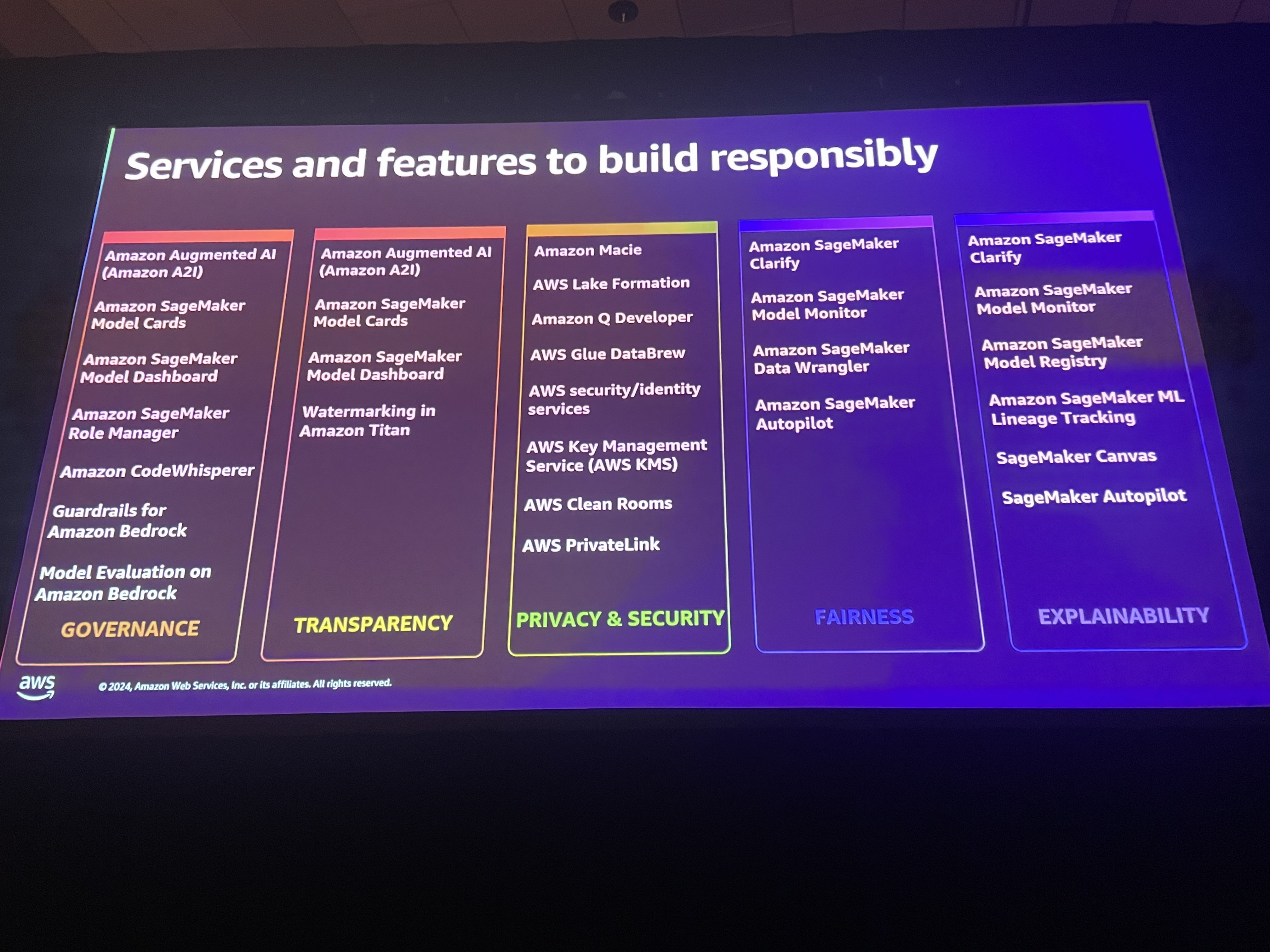

戦略としては5つのカテゴリに分かれます。ガバナンス、透明性、プライバシー&セキュリティ、公平性、 説明可能なAI です。

主要なAIモデル

現在提供されているClaudeの3つのバージョンが紹介されていました。

- Opus: 最も能力の高いモデル。

- Haiku: コスト効率が高く、応答速度が速いモデル。

- Sonnet: その中間のモデル。

その他の関連するAWSサービス

AWSサービスでは、デッドブックも利用するとができます。Cloudwatch を使用して専用ダッシュボードを構築し、監査目的に備えることも可能ですし、CloudTrailを使用して監査証跡も取得した上で、API アクティビティのトラブルシューティングを行うことも可能です。

また、すべてのリクエスト、回答者、メタデータをCloudWatch経由でログ保管を行うことができます。

Larkin Ryder氏によるAnthoropicのAIの取り組みについて

AI、安全性、セキュリティが組織の AI 実装にもたらすガバナンスの一部であることを確認するために、どのように役割を果たしているか?について説明がありました。

基礎となるモデル自体に安全性とセキュリティ上の懸念がある場合、安全性を高めるためにユーザ側でできることはたくさんあるのに、どのように対処すればよいでしょうか・・?対応も事後になってしまいますよね。

しかし、モデル自体に安全性を組み込むことができたらどうなるでしょうか?

Anthoropic社では、政府と規制に目を向けていて、重要視しています。

ISO 42001 などの標準を導入するという選択肢もAnthoropic社にはあります。

AI については、ぜひ皆さんにも検討していただきたいと考えています。生成AIの機能は劇的な速度で進化しています。私たちが AI で見ているのと同じ速度で、あらゆるテクノロジーの機能が拡張されているのを見た人もいると思います。

AI の安全性に関連するリスクの管理を目的とした政策の推進に役立つ AI の安全性研究に重点を置き、現在世界で利用可能なすべての政策を取り入れた一流モデルの開発にも取り組んでいます。

この取り組みは、今後もこれらのモデルの構築と安全性の向上を続けていくためです。